Ollama推出Web Search API,为LLM赋能实时网络搜索能力

Ollama上线了全新的“Web search”API功能,为大型语言模型(LLM)集成了实时网络搜索能力,这一创新举措将极大地提升LLM的智能性和实用性,使其能够更快速、更准确地获取互联网上的最新信息,从而更好地满足用户需求,这项功能将为用户带来更加便捷、智能的搜索体验。

ollama 正式发布“web search”api,使大语言模型具备实时获取互联网信息的能力,显著提升回答准确率并有效降低幻觉现象。

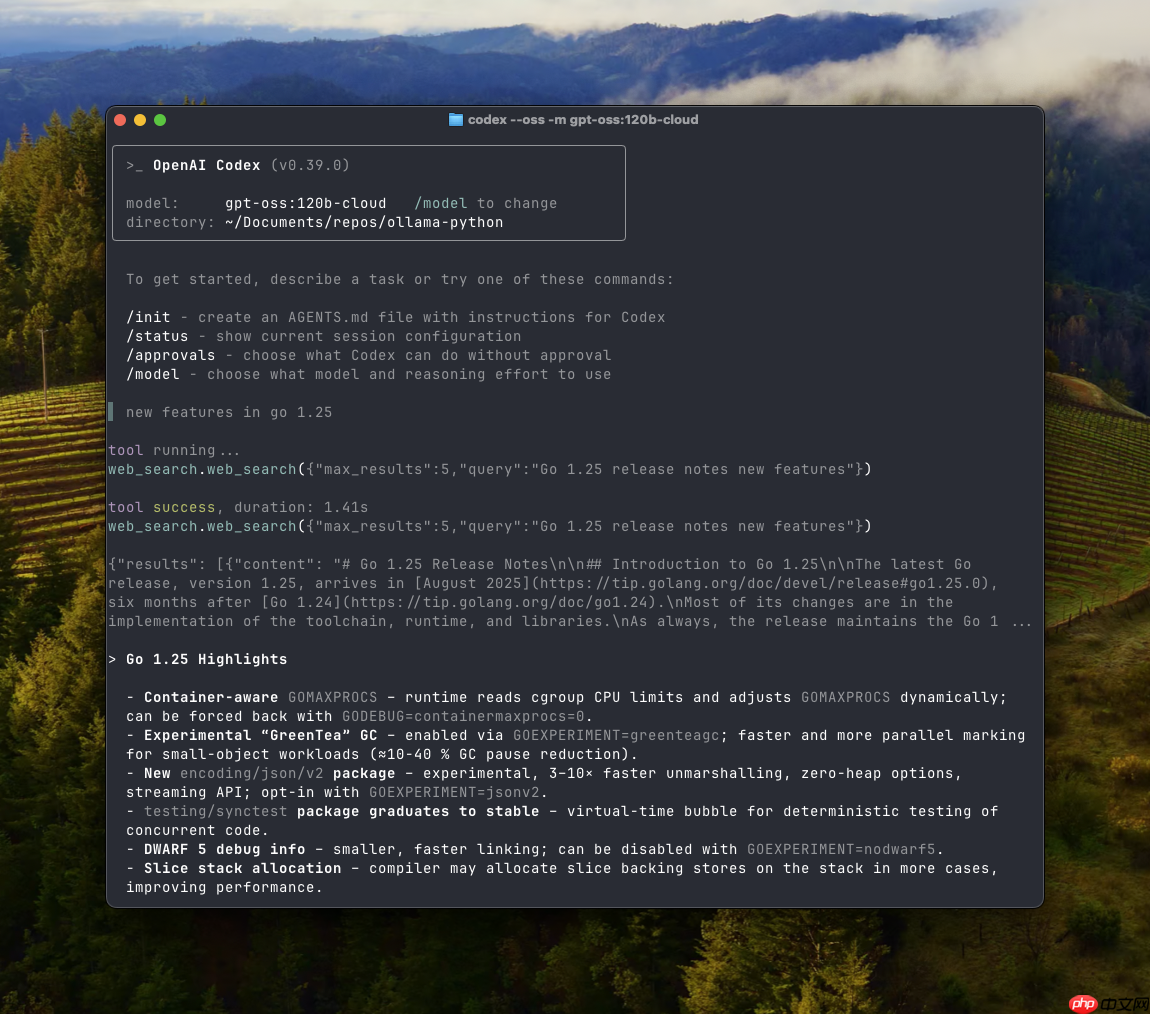

该功能以 REST API 形式开放,并已深度集成至 Ollama 的 Python 和 JavaScript SDK 中,便于开发者在各类应用中快速接入与调用。同时,平台还推出了 web fetch 接口,支持提取指定网页的完整结构化内容,包括标题、正文及链接信息。

借助 web search 与 web fetch,开发者可构建智能搜索代理系统,实现模型在对话过程中自主检索外部数据。该功能还兼容 MCP(Model Context Protocol) 配置环境,并可无缝集成至 Cline、Codex 等主流客户端中,拓展应用场景。

Ollama 提供免费试用额度,满足基础使用需求;如需更高请求频率和吞吐能力,用户可升级至付费方案。官方建议在使用上下文长度较大的模型(例如支持 32k tokens)时启用此功能,以便更高效地处理复杂的检索结果。

这一更新意味着 Ollama 模型将能融合实时网络信息进行推理与生成,为开发者打造更加智能、精准的 AI 应用提供强大支持。

源码地址:点击下载

<< 上一篇

下一篇 >>

网友留言(0 条)