谷歌发布长上下文基础模型升级版,TimesFM-2.5重磅亮相!

谷歌发布了名为TimesFM-2.5的长上下文基础模型,该模型具备强大的语言处理能力和广泛的上下文理解能力,可应用于自然语言处理的各种任务,如文本生成、机器翻译、情感分析等,TimesFM-2.5模型的发布为机器学习和人工智能领域带来了新的突破,有望为相关应用提供更加准确、高效的解决方案。

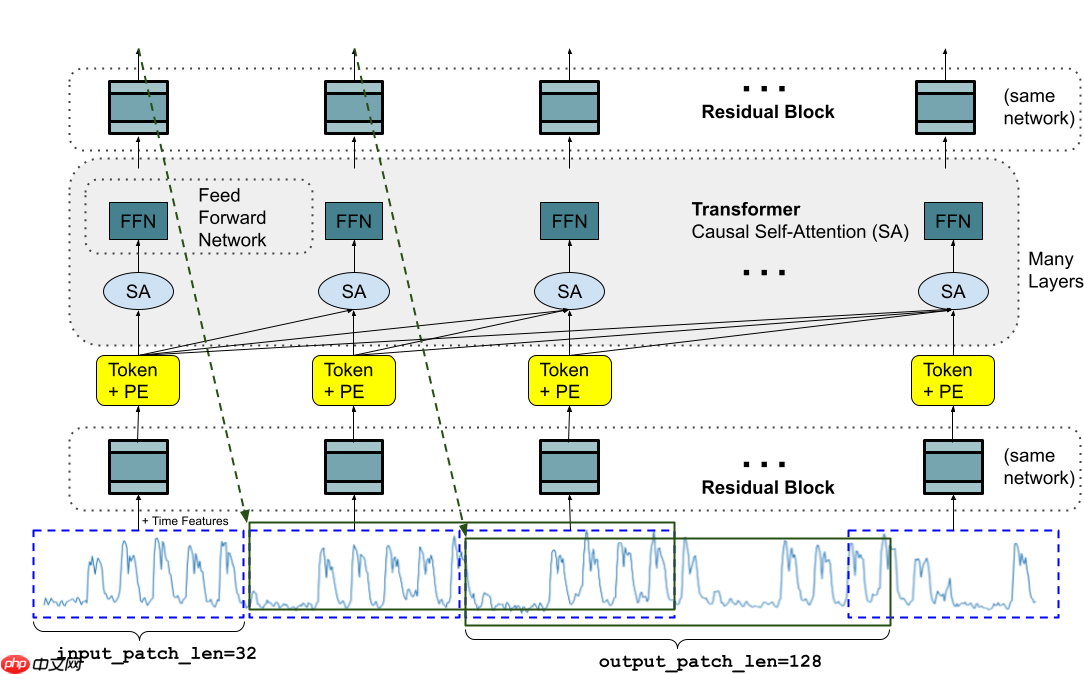

谷歌研究团队发布了timesfm-2.5,这是一个拥有2亿参数、采用纯解码器架构的时间序列基础模型。

与前代相比,TimesFM-2.5在将模型参数缩减一半的基础上,大幅延长了上下文长度,在运行效率和预测性能方面实现了重要突破。

TimesFM-2.5的核心优势包括:

- 轻量高效:参数规模降至200M,推理速度更快,同时精度进一步提升。

- 长期依赖建模:支持最高达16K长度的输入上下文,显著增强对历史数据的捕捉能力,适用于长期趋势预测。

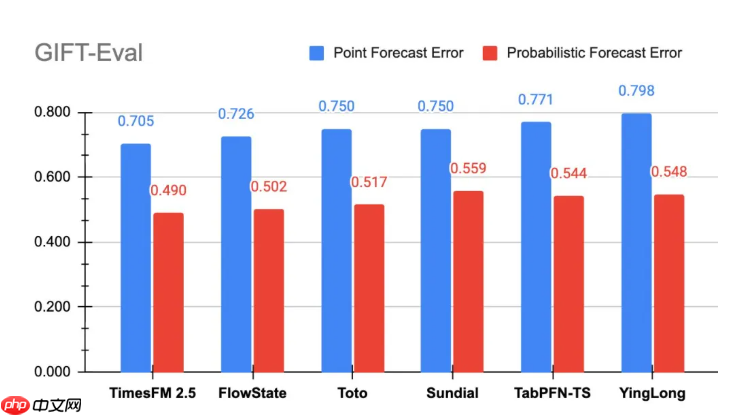

- 性能领先:在GIFT-Eval基准测试中,该模型于点预测与概率预测任务(以MASE、CRPS为指标)均位居榜首。

目前,TimesFM-2.5已正式在Hugging Face平台开放使用,同时正逐步与BigQuery及Model Garden实现集成,有望推动零样本时间序列预测在实际业务中的广泛应用。

https://www.php.cn/link/772c1c73d4ffe88046a3cdb8772e53eb

网友留言(0 条)