苹果智慧眼镜传闻概览,AI驱动与生态系统整合成焦点

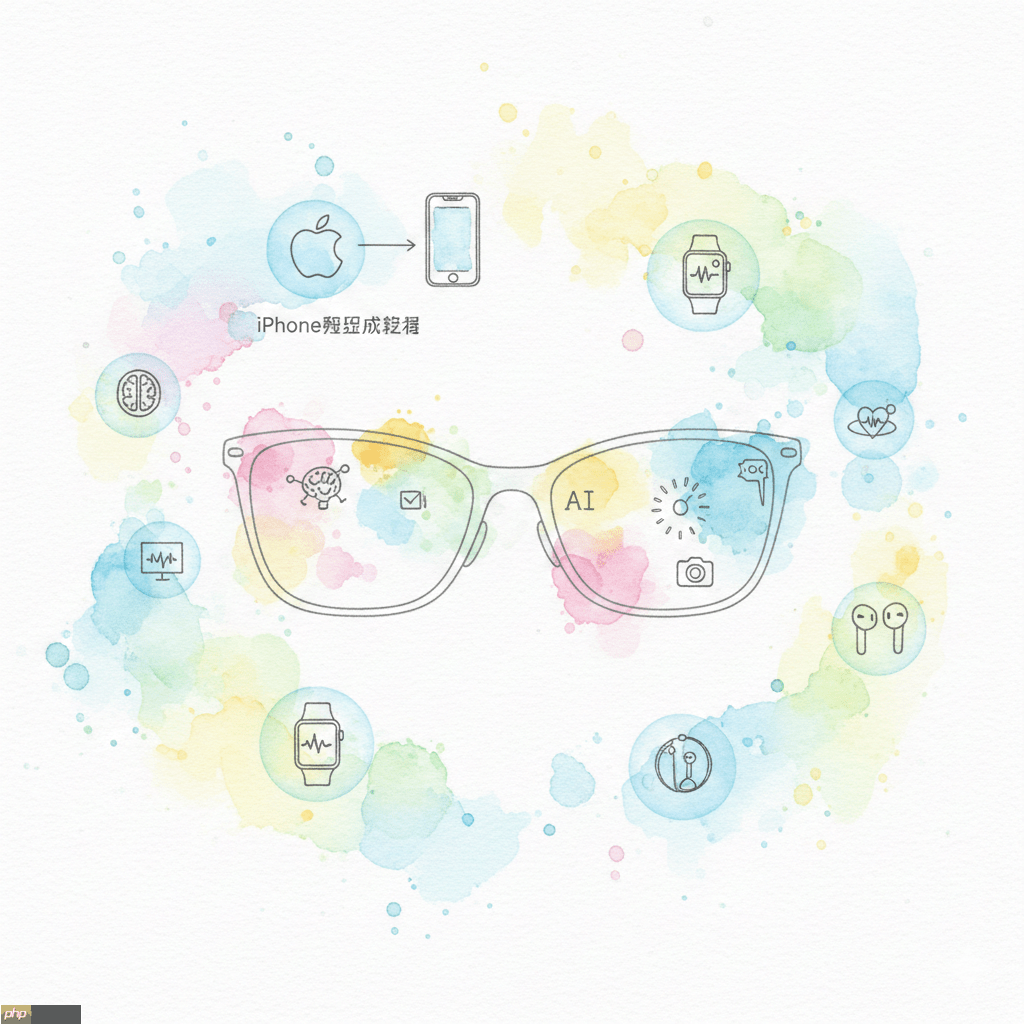

关于苹果智慧眼镜的传闻汇集,强调人工智能驱动和生态系统整合成为其亮点,这款眼镜预计将结合先进的AI技术,提供智能导航、健康监测和娱乐功能,与苹果现有生态系统的无缝融合,将为用户带来更加便捷的智能生活体验,具体细节有待官方进一步公布。

苹果首款智能眼镜apple glasses预计将于2026年正式发布,极有可能亮相于当年的苹果全球开发者大会(wwdc),并计划于2027年启动量产与上市销售。作为继vision pro之后苹果在ar与ai穿戴设备领域的关键落子,apple glasses并非全功能mr头显,而是定位为轻量级、高整合度的智能穿戴配件,主打日常高频使用场景。

尽管智慧眼镜概念早已存在,但Meta Ray-Ban系列的市场验证,叠加AI大模型端侧部署加速,促使苹果加快节奏。据多方权威信源确认,初代Apple Glasses将不配备显示屏,亦不支持传统意义上的AR叠加显示,转而聚焦AI驱动的视觉感知、语音交互与生态协同能力。

延伸阅读:

iPhone配件新革命?传苹果智慧眼镜有望2026抢先亮相、潜力超越Vision Pro

AI 门铃「认脸」是隐私或方便?Amazon Ring脸部辨识功能 市场反应两极

综合当前爆料信息,首代Apple Glasses的核心特性与硬件规划如下:

-

定制S级芯片:

基于Apple Watch S系列芯片技术深度优化,专为低功耗与多传感器协同设计,核心任务包括驱动多镜头模组、执行基础AI推理及保障续航表现

-

多摄视觉系统:

内置多枚微型摄像头,不仅支持高清拍照与录像,更作为“视觉输入中枢”,支撑视觉智能(Visual Intelligence)功能落地,如实时物体识别、场景理解与环境语义分析

-

Apple Intelligence深度赋能:

依托新版Apple Intelligence框架,眼镜可通过镜头持续理解用户所见内容,实现与iPhone、Mac等设备联动的跨端AI体验,功能逻辑延续iOS/iPadOS中已落地的视觉智能应用范式

-

全新Siri语音中枢:

全面升级的Siri将成为主要交互入口,支持自然语言指令、上下文连续对话及本地+云端混合AI响应;其实际体验水平,将直接影响产品口碑与用户粘性

-

内置音频输出单元:

配备微型扬声器,满足免提通话、语音反馈、简短音频提示等需求;同时兼容AirPods,形成双模音频方案,兼顾私密性与便利性

-

iPhone协同型架构:

采用类似Apple Watch的“配对依赖”设计,无独立蜂窝或完整计算模块,图像处理、大模型调用、复杂任务调度等均交由配对iPhone承担,强调无缝生态联动而非设备孤岛

-

健康监测探索中:

据彭博社等信源披露,苹果正评估集成非侵入式健康传感技术,可能涵盖眼部活动追踪、注视时长分析、环境光适应性调节等方向,但尚未确认是否首发搭载

-

时尚化产品形态:

延续Apple Watch的成功路径,Apple Glasses将提供多种镜框材质、配色与尺寸选项,覆盖不同脸型与穿搭风格,强化其作为“可穿戴时尚单品”的消费属性

虽然苹果并非该赛道先行者,但凭借其软硬一体化能力、iPhone装机量优势及Apple Intelligence生态纵深,Apple Glasses若如期落地,或将重新定义AI眼镜的用户体验标准——印证其一贯坚持的“不争第一,但求极致”的产品哲学。

下一篇 >>

网友留言(0 条)