Arcee AI发布开源MoE模型Trinity,引领创新浪潮的初创力量

美国初创公司 Arcee AI 发布了一款开源的 MoE 模型 Trinity,该模型具备强大的自然语言处理能力,可广泛应用于语音识别、机器翻译等领域,Arcee AI 致力于推动人工智能技术的创新与发展,此次发布的 Trinity 模型是其最新成果之一,该模型的开源性质将有助于促进全球范围内的学术交流和技术合作,推动人工智能技术的不断进步。

美国人工智能初创企业 arcee ai 近日发布了全新的开放权重模型系列 trinity,涵盖已上线的 trinity nano 与 trinity mini,以及预计于 2026 年 1 月发布的 trinity large。

该系列模型从数据采集、架构设计到训练流程均实现全栈自研,官方强调其“在美国完成端到端训练”,具备开放权重、强大推理性能及对开发者的全面控制能力。

Trinity 系列采用先进的多专家混合架构(afmoe),每层集成 128 个专家模块,每个 token 动态激活 8 个专家,并额外配备共享专家以增强泛化能力。训练基于超过 10T tokens 的高质量数据,并融合了 grouped-query attention、gated attention 及长上下文支持等关键技术,显著提升模型稳定性与推理效率。

- Trinity Nano:参数规模约为 6B 的 MoE 模型(激活参数约 1B),专为移动设备、嵌入式系统和注重隐私的本地部署场景优化。

-

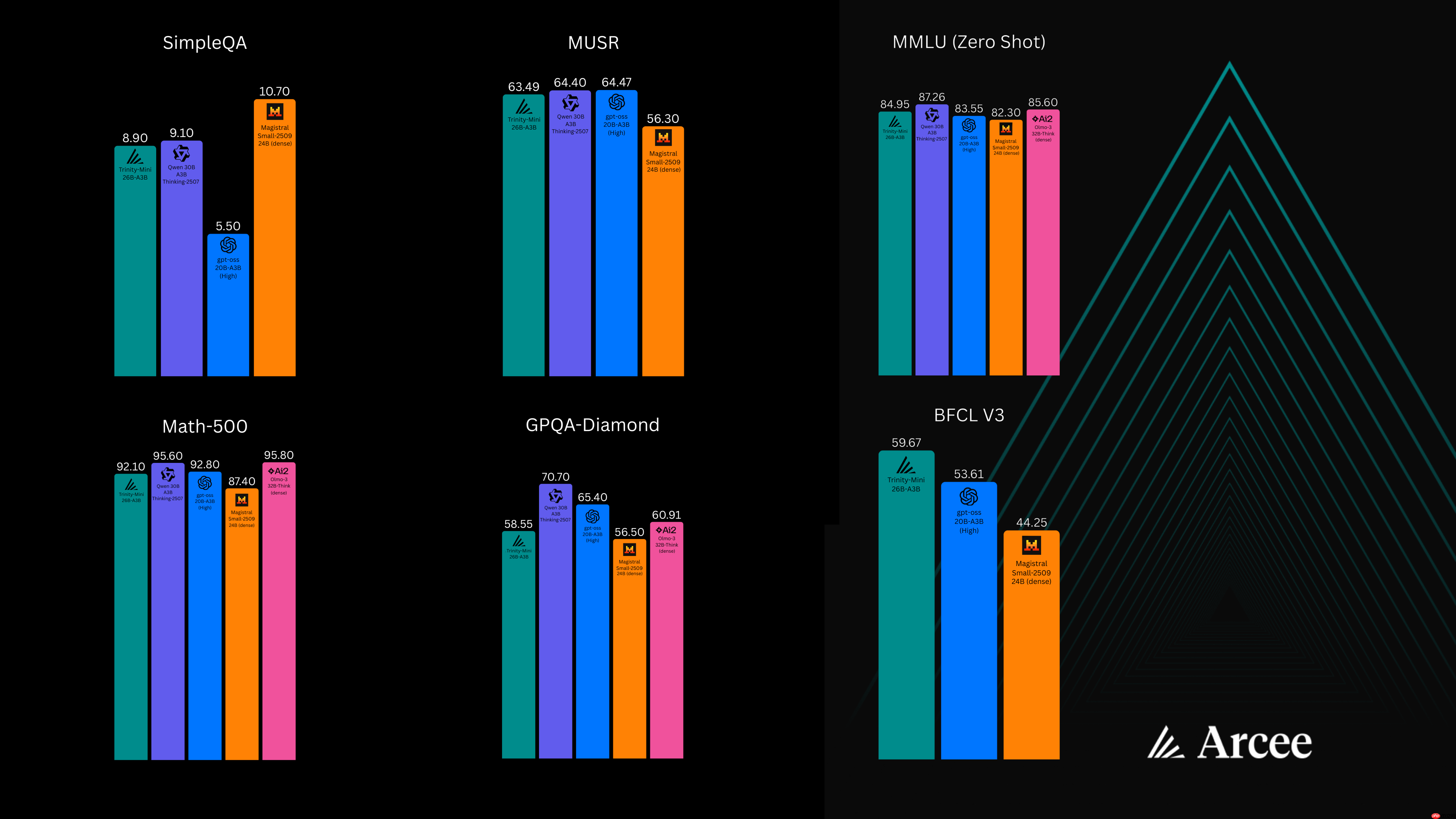

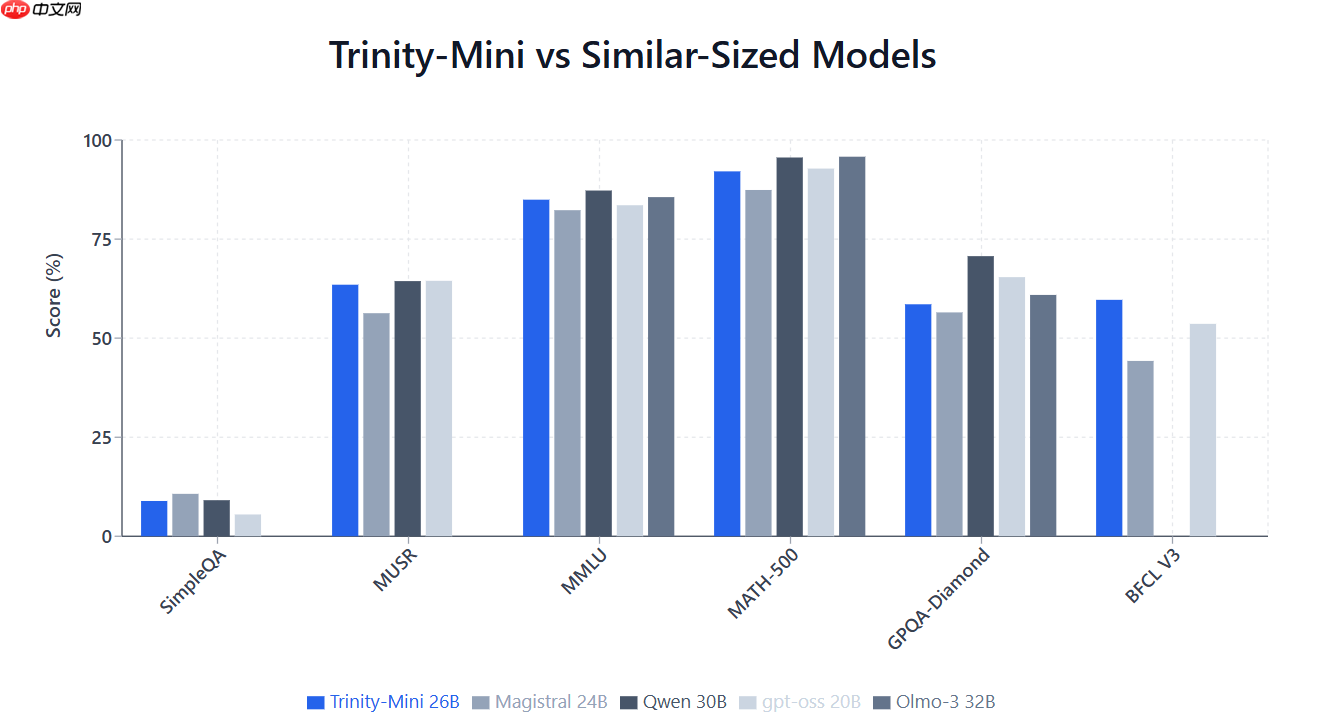

Trinity Mini:拥有 26B 参数的 MoE 架构(激活参数达 3B),适用于云端或本地数据中心,支持复杂多步推理、工具调用和超长文本处理任务。

两款模型均已开源,遵循 Apache 2.0 许可协议,用户可通过 Hugging Face 下载权重或调用 API 使用。

https://www.php.cn/link/f5685cb5d80c3249a9770cfd98cf71eb

Arcee AI 指出,当前多数所谓“开源”模型依赖第三方基础模型进行微调,存在能力瓶颈、数据不透明及合规风险等问题。Trinity 系列坚持从零开始自主预训练,旨在打造可长期演进、支持企业在私有环境中持续训练与迭代的可信 AI 基础设施。

公司还确认,Trinity Large 正在训练中,总参数量约 420B(激活参数约 13B),依托 2048 张 B300 GPU 构建的高性能集群,训练数据扩展至 20T tokens。完整技术白皮书将于 2026 年 1 月随模型发布时公开。

源码下载地址:点击获取

<< 上一篇

网友留言(0 条)